人間の医師よりもChatGPTの方が質が高く、患者に寄り添った回答ができる可能性 米論文

人工知能(AI)をベースとした大規模言語モデルを活用するチャットサービスが実用化されて以来、様々な分野でその有効性が話題になっているが、アメリカの研究者が、患者に対する応答能力に関して、AI チャットボット アシスタント「ChatGPT」と人間の医師を比較した論文を出し話題になっている。ChatGPTの回答が評価が医師の回答を大きく上回ったという。

ソーシャルメディアに寄せられた医学的質問に答える検証を実施

検証では、アメリカの有名ソーシャルメディア「Reddit」内に設置されている、医師に質問できるフォーラム「r/AskDocs)」に寄せられた質問から195 件をランダムに抽出、すでに回答されている医師の回答内容を収集したのち、ChatGPTの回答は、フォーラムに改めて元の質問を入力し答えさせることで収集した。評価は、回答の質と共感性について医療専門家のチームで行った。

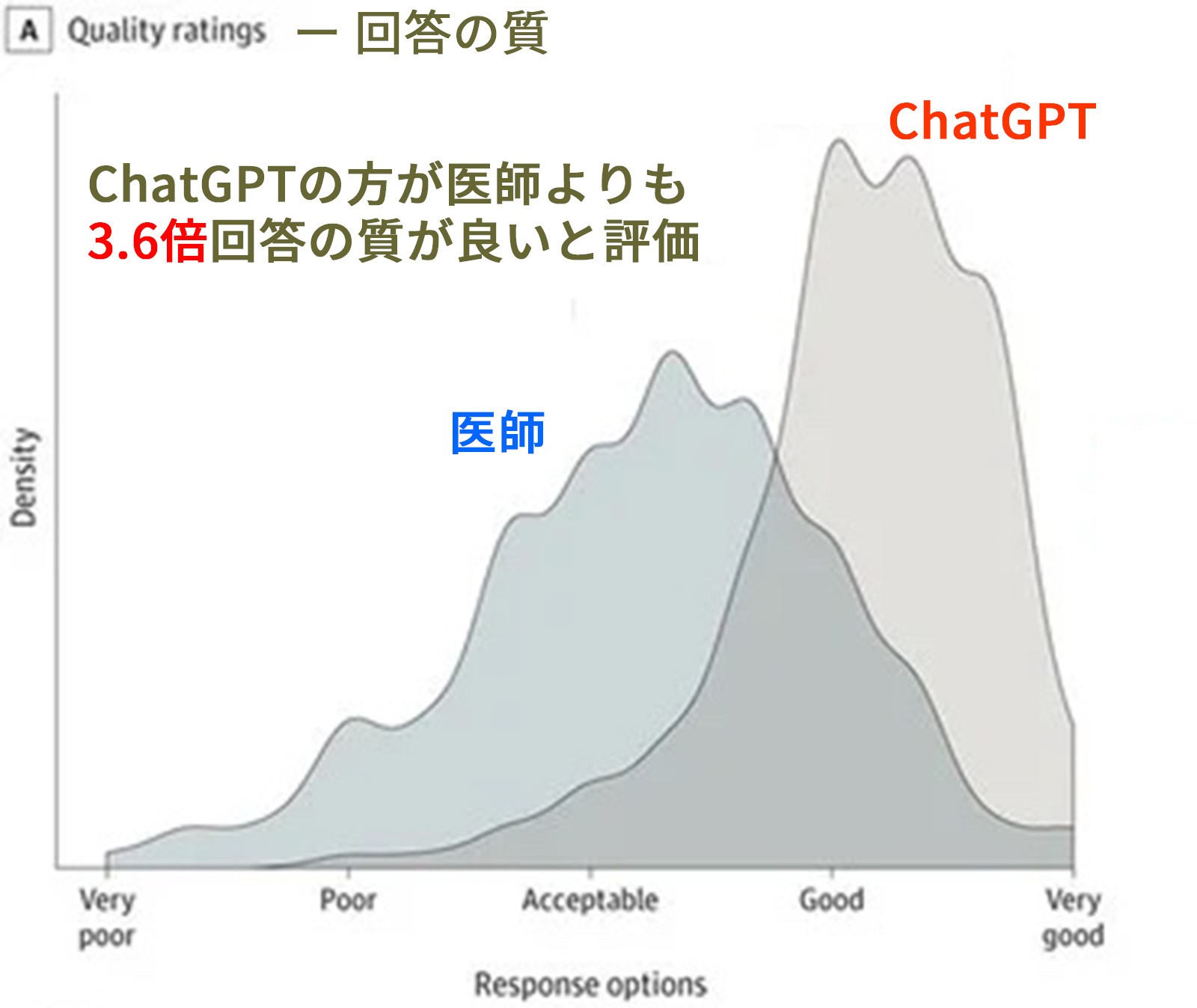

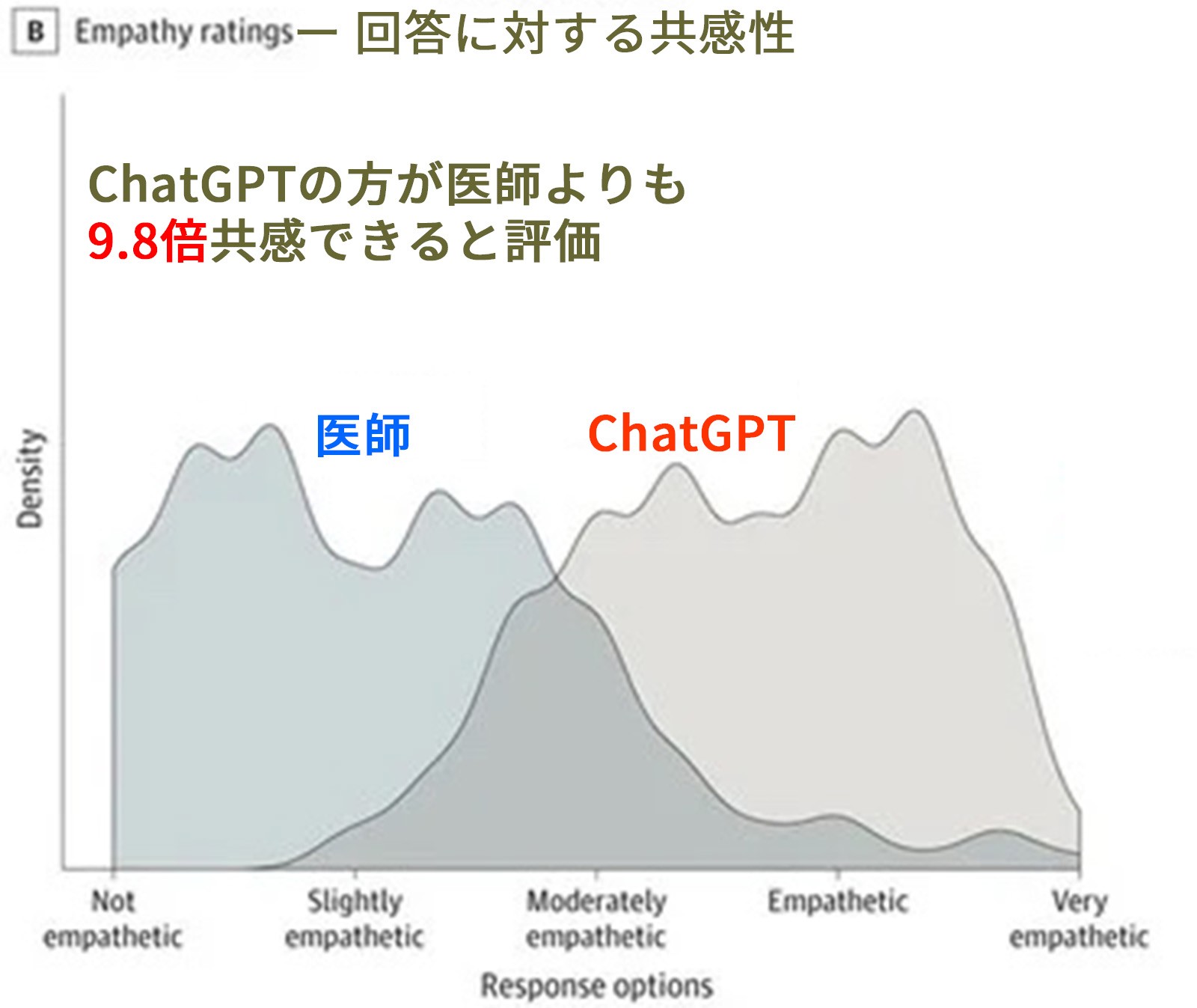

結果の概要は図表の通りで、回答の質においては、ChatGPTの回答の質が良いと評価した割合が78.5%、医師の場合は22.1%となり、ChatGPTの高評価が医師のそれを3.6 倍上回った。また回答に関する共感性に関してはさらに差が広がり、ChatGPTの回答の方が、医師の回答よりも9.8倍共感性が高いと評価された(ChatGPT=45.1%に対し医師:4.6%)。なお回答そのものに対して、ChatGPTの回答の方が、医師の回答よりも語数が多いことも分かった(ChatGPT211語に対し、医師52語)。

論文ではこの結果を受けて、医師がこうしたサービスを利用して回答をブラッシュアップすることの意義を示唆している。